1.1 Qu'est-ce que la physique des particules et des hautes énergies ? |

La physique des particules concerne l'étude des particules élémentaires qui composent toute la matière et la manière dont elles interagissent entre elles. Par "élémentaire" il faut entendre "qui n'a pas de structure interne connue". Ces particules sont donc, à l'heure actuelle, considérées comme ponctuelles.

Quand on visite un laboratoire de physique des particules, on peut s'étonner

de

la taille impressionnante des installations. A titre d'exemple, l'accélérateur LEP au

Centre Européen de Recherche Nucléaire (CERN), avec ses 27 km de circonférence, était

en ce début de 21 ème siècle le plus grand accélérateur du monde. Ses détecteurs,

eux aussi, sont immenses. Pour explorer le monde de l'infiniment petit, les physiciens

doivent disposer de "microscopes" gigantesques que sont les accélérateurs de

particules

et leurs détecteurs. N'y a-t-il pas là un paradoxe ?

Pour le résoudre, revenons quelques décennies en arrière. Au début du 20 ème siècle, les physiciens constatèrent que les faisceaux de particules avaient des comportements analogues à ceux d'une onde. A rebours, ils en déduisirent que la lumière était, en fait, constituée de particules qu'ils appelèrent des photons. Eclairer un objet revient doncà l'exposer à un flux de photons.

Pour étudier une particule, il faut trouver un moyen de l'" éclairer", c'est-à-dire d'envoyer sur elle un faisceau de particules-sondes. Dans le cas d'un microscope, par exemple, ces particules sont des photons mais ce n'est pas toujours le cas. Plus la structure que l'on veut étudier est petite, plus la longueur d'onde associée aux particules-sondes qui les frappent doit l'être aussi. La résolution est donc limitée par la longueur d'onde des particules servant de sonde. Et, comme celle-ci est d'autant plus petite que l'énergie est élevée, il faut donc que les physiciens disposent de très hautes énergies et, par conséquent, de très grandes machines.

1.2 Un peu d'histoire de la physique

|

|

Le concept de particule -ou celui d'atome, au sens éthymologique du mot- a été une idée philosophique avant d'être un sujet d'étude de la physique. LEUCIPPE et son disciple DÉMOCRITE (-470/-370) prétendaient que la matière était faite de particules éternelles et indestructibles appelés atomes. Le mot vient du grec et signifie insécable. Selon les atomistes, il n'y a dans la nature que des atomes et du vide. Les atomes se combinent au hasard pour former les objets qui nous entourent et les êtres vivants. Tous les éléments sont a priori différents.Leur forme peut expliquer certaines de leurs propriétés : les aliments sucrés, par exemple, sont formés d'atomes arrondis, alors que les aliments acides contiennent des atomes pointus. Les idées vagues des Grecs à ce sujet ne méritent pas le nom de théorie, elles ne possèdent pas les éléments structurants de la théorie atomique moderne. |

C'est l'anglais John DALTON (1766-1844) qui est connu comme le père de la théorie atomique. De ses observations sur les pressions partielles, qui s'expliquent facilement par l'hypothèse que les gaz sont formés de particules agitées, et de la loi des proportions définies, Dalton arriva naturellement à l'hypothèse que les différents éléments sont composés de particules indivisibles, toutes identiques, les atomes, et que les composés sont formés aussi de particules microscopiques (les molécules) obtenues en combinant les atomes des éléments correspondants d'une manière fixe et donc dans des proportions toujours identiques.

|

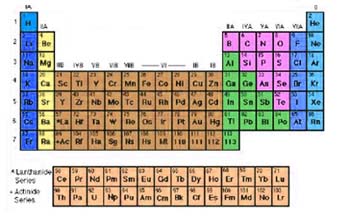

Dans la première moitié du 19ème siècle, la

liste des éléments connus s'allonge considérablement et les chimistes essayent d'y trouver une certaine structure pour y mettre un peu d'ordre. Le schéma le plus utile, celui qui s'imposa finalement, était l'oeuvre du chimiste russe Dimitri MENDELEÏEV (1834-1907). Celui-ci s'aperçut que certaines propriétés des atomes revenaient de manière périodique quand les éléments étaient arrangés dans l'ordre des poids atomiques croissants. Mendeleïev eut la bonne idée de laisser plusieurs cases vides dans son tableau et les associa à des éléments non encore détectés. Le fait que les éléments puissent être arrangés de manière périodique était une première indication, assez indirecte, que les atomes avaient une structure et n'étaient pas de simples objets indivisibles. Durant la période 1895-1900, le bestiaire de la physique s'enrichit de divers rayons : rayons cathodiques, rayons X, a, b, g. C'est l'époque de la découverte de la radioactivité, où l'on s'aperçut que l'atome (dont l'existence était encore mise en doute par une partie de la communauté scientifique) n'était pas aussi insécable et permanent qu'on le croyait... |

Peu de temps après, Joseph John THOMSON (1856-1940) fit l'hypothèse audacieuse que les atomes étaient constitués d'électrons emprisonnés dans une sorte de gelée de charge positive. Ce modèle de l'atome est appelé modèle du plum pudding, car Thomson comparait les électrons aux raisins du célèbre dessert anglais.

| Entre 1908 et 1911, Ernest RUTHERFORD (1871-1937) procéda à une série d'expériences dans lesquelles un faisceau de particules a (des noyaux d'Hélium) était lancé contre une mince feuille d'or. Si le modèle de Thomson était correct, les particules incidentes, beaucoup plus lourdes que les électrons, devaient être faiblement déviées. Or, un certain nombre de particulesétait dévié considérablement, certaines même vers leur point de départ. Rutherford disait que c'était aussi étonnant que si un obus lancé sur un mouchoir de poche rebondissait vers son point de départ ! La conclusion ne tarda pas : la charge positive n'est pas répartie dans tout le volume de l'atome mais concentrée au centre, dans un noyau dont la charge est un multiple entier de la charge de l'électron. |  |

En étudiant ainsi la diffusion de particules a sur divers atomes, Rutherford mesura les charges électriques des noyaux et s'aperçut que la classification de Mendeleïev correspondait à la suite des entiers positifs : un noyau dont la charge est Z fois la charge élémentaire (celle de l'électron) contient Z protons. Pour combler la différence entre la masse des Z protons et la masse de l'atome, Rutherford introduisit la notion de protons neutres, de masse voisine mais de charge nulle.

En 1930, des expériences firent apparaître une nouvelle sorte de rayons très

pénétrants

et impossibles à détecter directement. En 1932, James CHADWICK (1891-1974) émit

l'hypothèse que ce rayonnement était constitué de particules neutres, de la masse

du proton, et appela cette particule neutron. Dès lors, la structure du

noyau se clarifia :

un noyau de nombre atomique Z et de nombre de masse A devait contenir Z protons

et A-Z neutrons. Parallèlement, on découvrit avec surprise qu'une

certaine dose de radioactivité nous parvenait de l'espace, les rayons cosmiques.

En fait, les rayons cosmiques sont

des particules stables (protons, photons, électrons) de très haute énergies provenant de supernovae et

de trous noirs. Leur incidence sur les molécules de la haute atmosphère

terrestre crée une quantité d'autres particules. Les années qui suivirent furent

fructueuses en découvertes de nouvelles particules issues des rayons cosmiques,

qui

constituaient à cette époque la seule source de particules de hautes énergies.

Ceci stimula

le développement d'accélérateurs de hautes énergies pour révéler la structure

de

la matière.

Les physiciens se mirent donc à construire des appareils capables d'accélérer des particules à des énergies de plus en plus élevées et ne dépendirent plus des rayons cosmiques et de la radioactivité naturelle pour produire des projectiles propres à explorer la structure des noyaux. La technologie des accélérateurs de particules (cyclotron,synchro-cyclotron et ensuite synchrotron) s'accompagna d'une technologie également complexe de détection de particules.

Bien vite, une foule de nouvelles particules firent leur apparition : le muon en 1937, le pion en 1947 et des centaines d'autres dans les années 1950 et 1960. On se trouva rapidement dans le même dilemme que les chimistes avant la classification périodique des éléments. Le physicien américain Murray GELL-MANN émit alors l'hypothèse que la plupart de ces particules, comme les atomes, étaient composées de particules plus élémentaires qu'il appela quarks. Ainsi, le proton et le neutron étaient composés chacun de trois quarks. Gell-Mann réussit, comme Mendeleïev avant lui, à prédire l'existence d'une nouvelle particule, avec ses propriétés, à partir d'une place vacante dans son tableau (le W- , découvert en 1964).

Aujourd'hui, les physiciens disposent d'un cadre théorique qui décrit l'organisation

des particules élémentaires et comment elles interagissent entre elles par le biais

de forces. C'est le Modèle Standard. Pratiquement tous les résultats expérimentaux

d'expériences à hautes énergies peuvent être expliqués dans ce cadre.

1.3 Les unités et ordres de grandeur de la physique des hautes énergies |

Les unités de base du système international (SI) sont la longueur, la masse et le temps qui s'expriment respectivement en mètres, kilogrammes et secondes. Il apparaît qu'un tel système d'unités n'est pas approprié pour décrire des particules élémentaires.

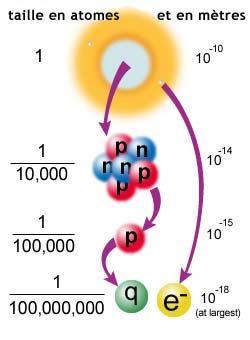

Les longueurs typiques, en physique des particules, sont de l'ordre de 10-15 m (environ la taille du proton) et les masses de l'ordre de 10-27 kg. D'autre part, il s'agit le plus souvent des phénomènes hautement relativistes c'est-à-dire, que les vitesses typiques sont de l'ordre de la vitesse de la lumière c = 2.998 108 m s-1.

Tab. 1: Unités en physique

des hautes énergies.

Finalement, la plupart des expériences consiste à introduire dans un potentiel électrique des particules de charge égale à celle de l'électron. L'électronvolt (eV) et tous ses multiples (1 keV=1000 eV, 1 MeV=106 eV, 1 GeV=109 eV, 1 TeV=1012 eV) seront donc des unités d'énergie plus appropriées. Comme son nom l'indique, l'électronvolt est l'énergie que gagne un électron accéléré par une différence de potentiel de 1 volt sur une distance de 1 m. Il vaut 1.6 10-19 J.

Ce que nous avons expliqué dans la section 1.1 en matière de particules-sondes signifie qu'une particule de quelques keV permet d'observer des systèmes de dimensions voisines de l'angström (10-10 m, la taille de l'atome), qu'à 100 MeV elle "voit" le femtomètre (1 fm =10-15 m, la taille du proton) et qu'à 100 GeV elle atteint le millième de femtomètre (c'est le cas du LEP).

En vertu de l'équivalence masse-énergie (E0 =mc2 , pour une particule au repos), on peut mesurer la masse dans des unités d'énergies divisées par le carré de la vitesse de la lumière c, par exemple, en MeV /c2. Mais le plus souvent, on l'exprime directement en unités d'énergies (MeV). Cela revient simplement à prendre la vitesse de la lumière comme unité de mesure de vitesses (c = 1). Exprimée dans cette unité, toute vitesse de particule est nécessairement inférieure ou égale à 1 puisqu'une particule ne peut pas aller plus vite que la lumière.

1.4 Einstein et les hautes énergies

|

|

Lors d'une collision entre particules élémentaires, celles-ci ne vont pas éclater comme on l'observe pour des objets macroscopiques. Comme elles est élémentaires, elles ne se brisent pas. C'est plutôt l'énergie du choc qui finit par se transformer en de nouvelles particules, en vertu de l'équivalence masse-énergie. Certaines particules créées sont les constituants ordinaires de la matière (protons, neutrons, électrons, photons, neutrinos), d'autres n'apparaissent que pour un très court instant. Ces dernières sont dites instables et se désintègrent donc en d'autres particules plus légères qui, elle-mêmes, peuvent être à nouveau instables et se désintégrer, etc, jusqu'à l'obtention de particules stables. Ainsi, lors de la collision, l'énergie est transformée en matière. |

Si la vitesse d'un objet est petite par rapport à celle de la lumière (la vitesse d'une voiture, par exemple), son énergie cinétique est donnée par la formule classique E=mv2/2 . Pour un électron possédant une énergie de 100 GeV, la vitesse est alors donnée par v = (2E / m)1/2 soit 187 683 374 km/s, ce qui correspondrait à 625 fois la vitesse c de la lumière dans le vide ! Or, la relativité d'Albert EINSTEIN (1879-1955) nous dit qu'il est impossible d'aller plus vite que la vitesse de la lumière. Où se trouve l'erreur ? Tout simplement dans la formule classique de l'énergie qui n'est plus valide. Il faut plutôt utiliser l'expression relativiste :

Dans le cas particulier d'une particule au repos (v = 0), elle se ramène à l'équation E0 = mc2 . Quand on dit "accélérer une particule dans un accélérateur", il s'agit, en général, plutôt de lui communiquer de l'énergie sans que sa vitesse augmente notablement, puisque cette particule circule déjà presque à la vitesse de la lumière. En somme, plus on lui donne d'énergie, moins on est efficace à l'accélérer.

1.5 Les interactions fondamentales

|

|

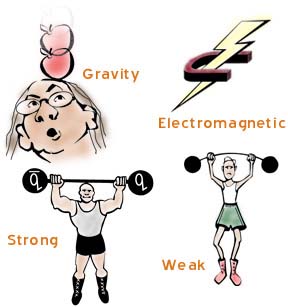

Toutes les forces présentes dans l'univers peuvent se ramener à quatre interactions fondamentales. L'interaction gravitationnelle est sans doute la plus familière. C'est elle qui est responsable de la chute des corps, du mouvement des planètes, etc. Elle est toujours attractive. L'interaction électromagnétique est la mieux comprise des quatre interactions. Elle est issue de l'unification faite par Maxwell de l'électricité et du magnétisme. La théorie de l'électromagnétisme appliquée au monde de l'infiniment petit s'appelle l'électrodynamique quantique. Cette interaction présente des ressemblances avec l'interaction gravitationnelle mais peut être attractive ou répulsive. L'interaction forte assure la cohésion des nucléons (protons et neutrons) à l'intérieur des noyaux et le confinement des quarks à l'intérieur des hadrons. C'est son intensité qui lui a valu son nom. Elle est responsable de la désintégration de particules hautement instables qu'on appelle résonances. L'interaction faible, finalement, est souvent présentée comme étant responsable de la radioactivité b, le phénomène par lequel le neutron se désintègre en proton (et d'autres particules). Elle initie les réactions thermonucléaires qui permettent au soleil de produire de l'énergie. Ces forces agissent à distance, c'est-à-dire sans que les objets ne se "touchent" et, pour ce faire, elles nécessitent l'intervention d'un messager qu'on appelle boson de jauge. Ainsi, le photon est le messager de l'interaction électromagnétique, les gluons ceux de l'interaction forte, les bosons W+, W - et Z0 ceux de l'interaction faible et le graviton celui de l'interaction gravitationnelle. |

La portée de l'interaction dépend de la masse de la particule messagère. Le photon, qui a une masse nulle, voyage à la vitesse de la lumière et la portée de la force électromagnétique est infinie. Il en est de même pour l'interaction gravitationnelle. Par contre, l'interaction faible n'agit qu'à très courte portée car les bosons W+, W - et Z0 ont des masses importantes à l'échelle des particules, respectivement 80 et 91 GeV/ c2. Le cas de l'interaction forte est un peu plus délicat car, bien que les gluons aient une masse nulle, sa portée est très courte, de l'ordre du fermi. Elle n'influence que les particules qui sont à l'intérieur du noyau.

Toutes les particules ne sont pas affectées pareillement par les interactions. Par exemple, le proton et l'électron, qui sont électriquement chargés, sont affectés par le photon, médiateur de l'électromagnétisme. Ils peuvent émettre ou absorber des photons. Par contre, le neutron, qui est neutre, ne ressent pas l'interaction électromagnétique.

Les interactions sont à l'origine de la cohésion de la matière mais elles régissent aussi les processus de transformation de particules en d'autres particules plus légères. Lorsqu'une particule instable se désintègre, c'est sous l'effet de l'une de ces interactions. Plus l'intensité de l'interaction, caractérisée par sa constante de couplage, est grande, plus la désintégration devient probable et plus la durée de vie de la particule est courte. Le tableau ci-dessous donne une idée des intensités relatives des différentes interactions pour deux protons juxtaposés.

Le temps de vie pour la désintégration des particules instables par le biais de l'une des interactions sont donc également très différents. Typiquement, le temps de vie moyen pour une désintégration faible est de l'ordre de 10-10 s alors que celui pour une désintégration forte avoisine les 10-23 s.

1.6 "L'union fait la force" ou plutôt "les forces font l'union" |

Le désir d'expliquer de façon synthétique les phénomènes est un principe moteur de la physique. Cette volonté d'unification a traversé les siècles, nombreux sont ceux qui s'y sont attelés. NEWTON, le premier, a compris que la chute des corps et le mouvement de la lune autour de la Terre sont régis par la même force. MAXWELL unifia l'électricité et le magnétisme. EINSTEIN, dans sa célèbre théorie de la relativité restreinte,établit un cadre propice à l'unification des descriptions de l'espace et du temps ainsi que celles de l'énergie et de la masse.

| Avoir pu réduire la description du monde physique connu à un jeu de seulement quatre forces constitue déjà une prouesse en soi. Mais les physiciens ne se sont pas arrêtés là. Les constantes de couplage, traduisant l'intensité des interactions, varient avec l'énergie mise en jeu (eh oui, le nom est assez mal choisi), de sorte qu'il existe une échelle d'énergie, de l'ordre de 1015 GeV, où elles deviennent comparables. D'où l'espoir de construire une théorie qui ne ferait appel qu'à une seule force. L'unification électrofaible (interactions électromagnétique et faible), opérée par SALAM, GLASHOW et WEINBERG en 1967, fut un premier stade décisif, mais se sont maintenant trois des quatre interactions fondamentales qui peuvent être fondues dans un même moule théorique. Seule la gravitation s'obstine encore à faire bande à part. |  |

1.7 Fermions et bosons |

Le spin est une propriété intrinsèque des particules qui est analogue mais pas identique au concept de "rotation sur soi-même" et qui lui confère des propriétés semblables à celle d'un petit aimant. Les particules (prises au sens large : atomes, particules composites ou élémentaires,...) peuvent être de deux types : de spin entier ou demi-entier. Les premières sont appelées bosons alors que les secondes portent le nom de fermions.

Les fermions obéissent au principe d'exclusion de Pauli qui stipule que deux fermions identiques ne peuvent exister dans le même état quantique. Ceci explique pourquoi les électrons sont disposés en couches autour du noyau et ne tombent pas tous dans l'état fondamental. Par contre, il n'y a aucune restriction sur le nombre de bosons dans le même état quantique. Ainsi, le phénomène laser est dû à un ensemble de photons dans le même état quantique.

Les fermions fondamentaux sont les véritables constituants de la matière. Ce sont d'un côté les quarks (sensibles à l'interaction forte), de l'autre les leptons (insensibles à l'interaction forte). Les bosons fondamentaux sont, quant à eux, les messagers associés aux quatre forces fondamentales. Ainsi en est-il, par exemple, du photon qui est associé à la force électromagnétique.

1.8 L'antimatière |

La notion d'antiparticule date de 1931. Il s'agit d'un objet de même masse, de même spin et de même temps de vie que la particule correspondante mais avec une charge électrique, un moment magnétique et électrique opposés. L'idée, quelque peu audacieuse pour l'époque, émane du physicien Paul DIRAC (1902-1984) qui cherchait l'équation capable de rendre compte du comportement d'un électron de haute énergie.

Le positron, l'antiparticule de l'électron, a été découvert expérimentalement par Carl ANDERSON (1905-1991) en 1932. Des antiparticules existent ainsi pour tous les fermions et les bosons. Elles forment l'antimatière, qui peut être créée en même temps que la matière pour peu que l'on dispose de suffisamment d'énergie. L'antiproton, de charge négative, fut découvert en 1955 et l'antineutron en 1956.

La notation retenue pour les antiparticules est d'inverser le signe de la charge si elle est indiquée (e+ , µ+). Dans le cas contraire, on utilise une barre au-dessus du nom de la particule ( ¯n, ¯p) Parfois, une particule peut être sa propre antiparticule. C'est le cas du photon et du pion neutre p0 . On peut s'étonner que le neutron, qui est neutre, lui aussi, ne soit pas identique à l'antineutron. Cela vient du fait que les particules sont caractérisées par ce qu'on appelle des nombres quantiques correspondant à des "charges" généralisées. La charge électrique en est un mais il en existe d'autres : le nombre baryonique, le nombre leptonique, la couleur, ... Les antiparticules ont des nombres quantiques opposés à ceux de leur particule.

Revenons-en au neutron. Celui-ci porte une charge baryonique + 1 alors que son homologue dans le monde de l'antimatière porte une charge baryonique - 1. Par conséquent, le neutron et l'antineutron ne sont pas identiques. Ce résultat a des conséquences pratiques : lorsqu'un neutron de basse énergie rencontre l'un de ses semblables, on assiste à une collision ordinaire, chacun d'eux repart dans une direction différente de sa direction incidente :

n + n ![]() n + n

.

n + n

.

Mais lorsqu'un neutron rencontre un antineutron, ils s'annihilent pour donner, par exemple, deux photons :

n + n ![]() g+ g.

g+ g.

1.9 Leptons et quarks |

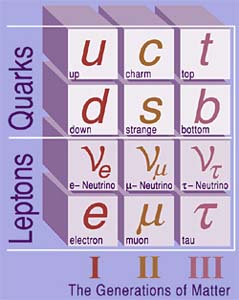

Parmi les fermions, on distingue deux familles : les quarks, qui ressentent l'interaction forte, et les leptons, qui y sont insensibles.

Les leptons sont dotés d'une charge électrique entière. L'électron e- avec une charge électrique négative est le plus connu. Le muon µ - (découvert en 1937) et le tau t - (découvert en 1975) ont la même charge que l'électron mais constituent des versions plus lourdes de celui-ci. On parle de trois saveurs leptoniques (e, µ et t). La saveur est le nombre quantique qui permet de déterminer comment les fermions fondamentaux réagissent à l'interaction faible. A chacune de ces saveurs est associé un neutrino, dénoté par la lettre grecque n(ne, nµ et nt ). Les neutrinos ont une charge électrique nulle et une très petite masse. Le muon et le tau ne se trouvent pas dans la matière ordinaire car ils sont instables, c'est-à-dire qu'ils se désintègrent spontanément en d'autres particules plus légères comme l'électron et les neutrinos :

![]()

Le temps de vie moyen du muon est 2.2µs (2.2 10-6 s) alors que celui du tau est encore beaucoup plus petit, 0.29ps (0.29 10-12 s). L'électron et les trois types de neutrinos, par contre, sont stables. L'existence des neutrinos a été postulée par Wolfgang PAULI (1900-1958) en 1930 dans le but de rendre compte de l'énergie manquante dans les désintégrations b du neutron.Cependant, ils interagissent si faiblement avec le reste de la matière qu'ils n'ont pas été détectés avant la fin des années 1950.

Le terme de "quarks" date de 1964 quand Murray GELL-MANN et George ZWEIG suggérèrent que les centaines de particules connues à l'époque pouvaient être expliquées comme des combinaisons de trois particules fondamentales qu'ils choisirent d'appeler "quarks". Le mot provenait du roman Finnigan's Wake de James Joyce : "Three quarks for Muster Mark". Pour que l'hypothèse des quarks tienne la route, il fallait leur attribuer des charges fractionnaires 2/3 et -1/3. De telles charges n'avaient encore jamais été observées. Les quarks étaient donc considérés comme des abstractions mathématiques. L'expérience a prouvé que non seulement ces trois quarks existaient mais qu'il en existait d'autres.

|

On recense actuellement six saveurs de quarks : up (u), down (d), charm (c), strange (s), top (t ), bottom (b). Les quarks b, c, s et t , beaucoup plus lourds que leurs confrères u et d, se désintègrent rapidement en ces derniers. On ne les retrouve donc pas dans les structures stables connues. En plus de leur charge électrique et de leur saveur,

les quarks portent une charge dite de "couleur" qui

les rend sensibles à l'interaction forte. Il existe trois

couleurs, disons rouge, vert et bleu. Mais attention,

dire que les quarks portent une charge de couleur ne

veut pas nécessairement dire qu'ils sont colorés. C'est

simplement une manière analogique de désigner une

sorte d'étiquette quantique qu'ils portent et que l'on a convenu d'appeler couleur.

Les Etant donné que l'absorption et l'émission d'un gluon change la couleur

des quarks

mais que celle-ci est une quantité conservée lors de l'interaction, on peut considérer

que les gluons sont porteurs d'une couleur et d'une anticouleur. La séquence

ci-dessous

illustre l'émission d'un gluon par un quark provoquant un changement de |

![]()

![]()

![]()

![]()

![]()

Les neuf combinaisons de couleurs possibles laissent à penser qu'il doit exister neuf gluons mais les mathématiques font en sorte qu'il n'en existe que huit.

FIG. 1.1 – Les fermions du Modèle Standard.

TAB. 1.2 – Tableau des fermions élémentaires. |

TAB. 1.3 – Tableau des interactions fondamentales |

1.10 Hadrons, baryons, mésons |

Seules les particules sans couleur sont observées et, par conséquent, les quarks et les gluons ne s'observent jamais seuls. Ils s'arrangent toujours pour former des com-binaisons de charge électrique entière et de couleur neutre qu'on appelle des hadrons. On dit que les quarks sont "confinés" à l'intérieur des hadrons.

|

On distingue deux types de hadrons. D'une part, les baryons, qui sont des fermions, sont composés de trois quarks (qqq) de couleurs différentes. Les protons, composés de deux quarks u et d'un quark d, et les neutrons, composés de deux quarks u et un quark u, sont de ceux-là. D'autre part, les mésons qui sont des bosons, quant à eux, sont composés d'un quark d'une couleur et d'un antiquark de l'anticouleur (q ¯q). Parmi eux, on compte, par exemple, les pions (p+, p-, p0). A l'intérieur des hadrons, il arrive que l'énergie des quarks de valence (constituants "officiels" des baryons et des mésons) se transforme en matière. Quarks et antiquarks apparaissent, se rencontrent, s'annihilent continuellement. On les appelle les quarks de la mer. Par l'échange incessant de gluons qui sont colorés, la couleur des quarksà l'intérieur des hadrons est changée.

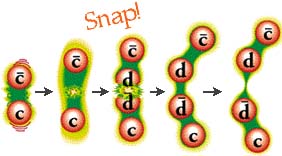

|

L'intensité de l'interaction entre deux objets colorés augmente à mesure qu'ils s'éloignent l'un de l'autre, ce qui explique que les objets colorés doivent rester confinés à l'intérieur des hadrons et ne peuvent exister librement. Au fur et à mesure que deux quarks s'éloignent l'un de l'autre, la création d'une paire quark-antiquark devient énergétiquement plus favorable. C'est ce qu'on appelle la fragmentation. Les quarks résultant se combinent pour former des hadrons. Ce processus est celui de l'hadronisation. Les quarks se manifestent donc par des jets de hadrons.

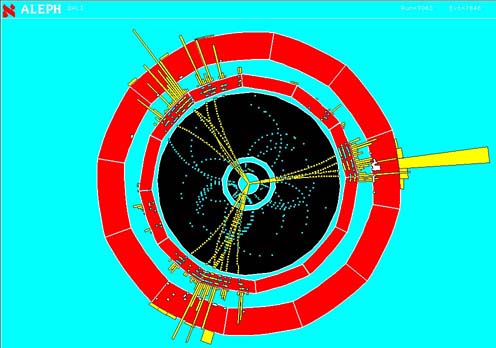

Un jet peut également provenir de l'émission d'un gluon par un quark. Ainsi

l'image 1.2 représente un événement avec trois jets provenant de deux quarks et d'un

gluon. Ce genre de topologie a été observé pour la première fois à DESY (Hambourg,

Allemagne) en 1979.

FIG. 1.2 – Visualisation d'un événement à trois jets provenant de deux quarks

et d'un

gluon.

Quand, en physique nucléaire, on parle de désintégration d'un noyau, il s'agit d'une scission de celui-ci en des noyaux plus petits. Par exemple,

235U ![]() 231Th

+ a

231Th

+ a

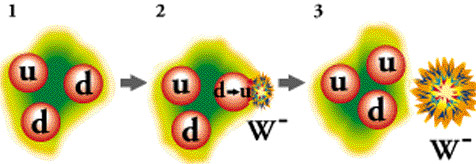

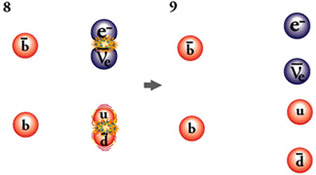

En physique des particules, il n'en est pas de même. La désintégration d'une particule élémentaire fait référence à la transformation de cette particule en d'autres particules fondamentales. Nous avons évoqué précédemment quelques exemples de désintégration (désintégration du µ et du t, désintégration b du neutron). Celles-ci sont occasionnées par l'interaction faible, seule capable de modifier la saveur d'un lepton. Ainsi, par exemple, dans la désintégration b du neutron, un quark d se transforme en un quark u en émettant un boson W (figure 1.3).

FIG.

1.3– Schéma explicatif de

la

désintégration b du neutron.

Les interactions électromagnétique et forte peuvent également être responsables de désintégrations. Le pion neutre p0 est un mélange de u¯u et de d¯d. Le quark et l'antiquark peuvent s'annihiler et donner lieu à l'émission de deux photons. C'est un exemple d'une désintégration électromagnétique. La particule hc est un méson c¯c. Elle peut subir une désintégration forte en deux gluons.

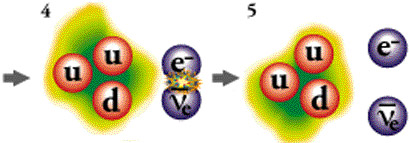

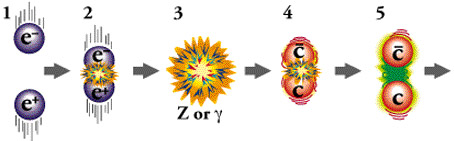

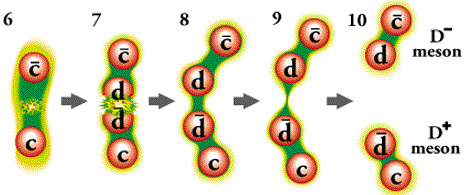

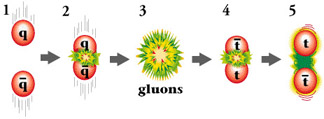

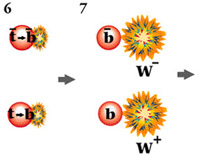

D'autre part, les particules peuvent s'annihiler entre elles, convertissant leur énergie pour donner naissance à un boson intermédiaire, messager de l'une des interactions fondamentales. Celui-ci, à son tour, convertit son énergie pour donner naissanceà d'autres particules. Au LEP, les physiciens provoquent des collisions entrent des électrons et des positrons de manière à faire apparaître d'autres particules, par exemple, une paire de mésons D+D - comme illustrée à la figure 1.4. Dans un collisionneur proton-antiproton, ce sont les quarks et antiquarks, constitutifs des nucléons initiaux, qui s'annihilent, par exemple, comme à la figure 1.5.

|

|

FIG. 1.4– Schéma explicatif de l'annihilation e+e- en une paire q ¯q suivie de l'hadronisation en D+D -.

|

|

|

1.12 La quête du Higgs |

La théorie électrofaible réunit, comme son nom l'indique, l'électromagnétisme et l'interaction faible. On pourrait se demander comment il se fait que les trois médiateurs de l'interaction faible (W+, W - et Z0 ) aient une masse alors que le médiateur de l'interaction électromagnétique, le photon, n'en a pas. Cette différentiation est attribuée à un mécanisme énigmatique, le mécanisme de Higgs, par lequel on prétend interpréter l'origine des masses des particules en "brisant la symétrie" entre les bosons de l'interaction électrofaible. Il nécessite l'introduction d'une nouvelle particule (de spin 0) que l'on appelle boson de Higgs. La théorie électrofaible ne demande au boson de Higgs que d'exister, elle ne dit rien sur sa masse, sinon qu'elle peut difficilement excéder 1 TeV sans remettre en cause tout l'édifice. Alors, depuis plus de 20 ans, les physiciens traquent cette particule. En 2000, le LEP (voir section 2.2) a été poussé au bout de ses limites pour tenter de la mettre en évidence. Jusqu'à présent, la quête est restée infructueuse dans l'intervalle entre 0 et 115 GeV /c2. D'autre part, la masse du Higgs ne devrait pas excéder 160 GeV /c2. La traque se précise. On compte maintenant surtout sur le LHC (Large Hadron Collider), en construction au CERN, pour poursuivre les recherches.

Reste la possibilité que le fameux boson ne soit pas au rendez-vous ! Ne pas trouver le Higgs reviendrait à prouver qu'il n'existe pas. Et, dans ce cas, quelque chose d'autre doit exister, particule ou phénomène nouveau que le LHC donnera à voir. Ce ne serait pas la première fois qu'un accélérateur apporte de l'imprévu!